Optimiser ses liens pour la planète

Un site, des liens, des robots…

On estime que 32% du trafic sur internet est réalisé par les robots d’exploration des moteurs de recherche.

Ce qu’il faut savoir c’est que les robots sont de véritables goinfres d’urls et explorent tout ce qui leur est donné. Chaque url sera parcourue et donc chaque url a un coût énergétique.

Optimiser ses liens c’est donc limiter la charge de travail des bots et, par la même occasion, limiter leur consommation de ressources énergétiques.

Le problème est que pour chaque url créée sur un site, plusieurs autres liens sont créés dans le même temps :

- url oEmbed (page embarquée)

- url oEmbed au format XML

- url JSON pour le REST API

- url raccourcie de type ?p=123

- url du flux des commentaires, s’il y en a sur la page ou l’article

- url de l’auteur

- url de l’étiquette

- url de la catégorie

- etc

Alors que certains de ces liens sont bel et bien nécessaires pour votre SEO, d’autres sont complètement inutiles.

En plus de ces liens multiples sur vos publications, certaines extensions vont en ajouter encore et encore, selon leurs fonctionnalités.

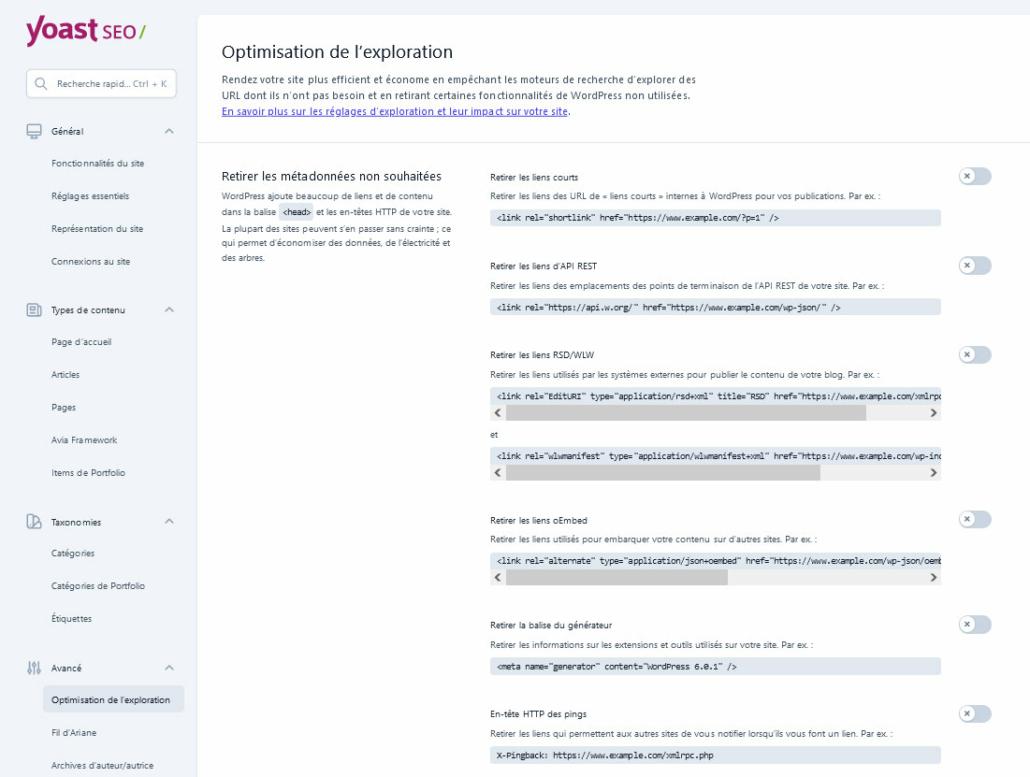

Optimiser ses liens avec Yoast SEO

L’extension Yoast SEO vous assiste et vous permet d’optimiser vos liens, via son écran « optimisation de l’exploration », en menu « yoast seo/réglages/avancé ».

Optimiser en « négociant » avec les robots

Enfin, n’oubliez pas que vous pouvez toujours également restreindre la charge d’exploration des robots en vous adressant directement à eux, via votre fichier « robots.txt », et cela même s’ils ne vous écoutent pas toujours, comme avec la directive « no-follow« , ou encore les directives qui ne sont prises en compte que sur certains moteur de recherche (Google, Bing, Yandex, …).

Vous pouvez également tenter la directive « crawl-delay » qui, comme son nom l’indique, donne une consigne de délai entre les explorations.

Un exemple significatif : donner un délai de 10 (secondes) [crawl-delay: 10] autorisera l’exploration de quelques 6840 liens de votre site par jour! Avec un délai de 30, la masse d’exploration baissera à 2880 urls par jour !

Sources :